作者簡(jiǎn)介:陸小華,男��,江蘇徐州人,天津大學(xué)新媒體與傳播學(xué)院講席教授�����,博士生導(dǎo)師�,研究方向:民商法��;陸賽賽�����,女��,河北石家莊人���,天津大學(xué)法學(xué)院博士研究生��,研究方向:民商法���。

摘要:人工智能廣泛的致害風(fēng)險(xiǎn)挑戰(zhàn)了侵權(quán)法適配于人類行為的過錯(cuò)標(biāo)準(zhǔn)。現(xiàn)有研究旨在通過構(gòu)建龐大的注意義務(wù)體系��,以厘定行為界限��,兼具理論與實(shí)踐的局限性�。正視人工智能侵權(quán)行為的可過錯(cuò)性,拓展合理性分析框架�,構(gòu)建“合理的人工智能”標(biāo)準(zhǔn),能夠更好地實(shí)現(xiàn)技術(shù)發(fā)展與保護(hù)受侵害權(quán)益之間的平衡���。在靜態(tài)結(jié)構(gòu)層面����,構(gòu)建“合理的人工智能”標(biāo)準(zhǔn)必須考慮價(jià)值判斷�、合理的人工智能的自身狀況和案件環(huán)境三大要素。在動(dòng)態(tài)運(yùn)作層面���,應(yīng)當(dāng)更加注重判斷注意義務(wù)之違反��,以人類行為���、其他機(jī)器行為作為二元評(píng)估對(duì)象,經(jīng)由比較與計(jì)算的雙重階段�����,搭建違反“合理的人工智能”標(biāo)準(zhǔn)的判斷模型�����。在場(chǎng)景應(yīng)用層面,“合理的人工智能”標(biāo)準(zhǔn)需要借由具體案件展開并予以明確���,同時(shí)兼顧技術(shù)理性及價(jià)值判斷�。

關(guān)鍵詞:過錯(cuò)���;機(jī)器行為����;注意義務(wù)����;合理性分析;合理的人工智能

一����、問題的提出

數(shù)智時(shí)代,人工智能侵權(quán)事故頻繁出現(xiàn)并不斷擴(kuò)張�����。最初��,引發(fā)關(guān)注的是自動(dòng)駕駛汽車侵權(quán)及診療人工智能侵權(quán)這兩類案件。但眾所周知�����,目前自動(dòng)駕駛汽車的事故率遠(yuǎn)低于人類司機(jī)��,加之我國(guó)相關(guān)法律文件對(duì)診療人工智能輔助地位的強(qiáng)調(diào)�,這在一定程度上削減了公眾對(duì)上述侵權(quán)風(fēng)險(xiǎn)的擔(dān)憂����。然而,ChatGPT的火爆出圈極大拓寬了人工智能的應(yīng)用領(lǐng)域����,引發(fā)了侵害人格權(quán)及著作權(quán)的廣泛風(fēng)險(xiǎn)。不止如此��,中國(guó)公司研發(fā)的DeepSeek R1于2025年1月20日發(fā)布���,不僅只用7天獲得億級(jí)用戶��,而且采用開源策略為多種產(chǎn)業(yè)賦能��,目前全球多領(lǐng)域頭部企業(yè)已經(jīng)接入DeepSeek以構(gòu)建AI生態(tài)���。2025年2月7日�����,優(yōu)必選公司表示�����,其已在具身智能應(yīng)用場(chǎng)景中驗(yàn)證DeepSeek技術(shù)的有效性�,有望利用推理模型解決復(fù)雜任務(wù)從而賦能萬億產(chǎn)業(yè)集群���。在可預(yù)見的未來�,具身智能作為物理世界的通用平臺(tái)�����,將代替人類承擔(dān)更復(fù)雜的角色���。國(guó)內(nèi)層面����,我國(guó)于2023年就發(fā)布了《人形機(jī)器人創(chuàng)新發(fā)展指導(dǎo)意見》�,前瞻性地指出具身智能擁有巨大市場(chǎng)應(yīng)用潛力��,并確定于2025年初步建立人形機(jī)器人創(chuàng)新體系的戰(zhàn)略目標(biāo)�。這也就意味著���,一旦成千上萬以大模型為驅(qū)動(dòng)的具身智能投放市場(chǎng)����,那么�����,人工智能在現(xiàn)實(shí)中可能侵害的權(quán)益種類和范圍都將急劇擴(kuò)張�����。

時(shí)值我國(guó)人工智能立法的機(jī)遇期和窗口期����,法律尤其需要對(duì)人工智能侵權(quán)責(zé)任的認(rèn)定作出積極回應(yīng)����。劃定人工智能行為(以下簡(jiǎn)稱機(jī)器行為)的界限,確立人工智能侵權(quán)中的過錯(cuò)標(biāo)準(zhǔn)���,應(yīng)屬當(dāng)務(wù)之急���。然而����,學(xué)者對(duì)人工智能法律主體地位��、人工智能侵權(quán)中因果關(guān)系�、侵權(quán)主體等問題多有討論,卻唯獨(dú)對(duì)過錯(cuò)問題避而不談�。即使談?wù)撨^錯(cuò),相關(guān)爭(zhēng)議亦圍繞過錯(cuò)是否應(yīng)為人工智能侵權(quán)責(zé)任構(gòu)成要件展開�,亦或集中于討論服務(wù)提供者甚至用戶的注意義務(wù)��。誠(chéng)如部分學(xué)者所言���,人工智能應(yīng)用責(zé)任確系當(dāng)下研究重點(diǎn)��,探討與人工智能相關(guān)的應(yīng)用主體(以下簡(jiǎn)稱相關(guān)主體)的過錯(cuò)�����,諸如自動(dòng)駕駛汽車使用者是否負(fù)擔(dān)接管義務(wù)等問題自有其價(jià)值。但需要警惕的是�,將相關(guān)主體的過錯(cuò)與人工智能侵權(quán)中的過錯(cuò)混為一談。前者關(guān)注的是人工智能應(yīng)用者���、使用者一方的風(fēng)險(xiǎn)損害承擔(dān)問題�,后者關(guān)注的則是機(jī)器行為本身是否具有合理性的問題�����。兩者本應(yīng)相互補(bǔ)充����,共同解決人工智能侵權(quán)責(zé)任承擔(dān)問題���。但是�����,在當(dāng)前的研究語境中��,相關(guān)主體的過錯(cuò)與人工智能侵權(quán)中的過錯(cuò)����,兩者并無明顯區(qū)分,甚至有混同之嫌�����。

究其原因�,在當(dāng)前“人工智能非主體性”的主流語境之下,探討人工智能本身的過錯(cuò)似乎毫無意義�。但是,直接將人類的過錯(cuò)等同于人工智能的過錯(cuò)����,是否具有合理性呢?二者又真的能夠等同嗎�?顯然,現(xiàn)有研究普遍缺乏對(duì)這一問題的省思�。縱觀已有研究����,主體與過錯(cuò)的相互糾纏只能給人工智能侵權(quán)責(zé)任的認(rèn)定帶來更多的困擾。最直接的危害表現(xiàn)為�,所有應(yīng)用主體均被施加了更多、更重的注意義務(wù)����。值得追問的是���,傳統(tǒng)責(zé)任制度只著眼于約束人類行為,真的能夠?qū)崿F(xiàn)減少人工智能侵權(quán)的法律效果嗎���?本文認(rèn)為�����,相比于探討人類過錯(cuò)��,更應(yīng)當(dāng)正視機(jī)器行為的合理性問題���。只有為人工智能設(shè)定自身的行為標(biāo)準(zhǔn),才能真正預(yù)防和減少人工智能侵權(quán)�����。何種機(jī)器行為是侵權(quán)行為���?判斷標(biāo)準(zhǔn)如何確定?以上問題不僅僅是關(guān)乎權(quán)利保護(hù)與產(chǎn)業(yè)發(fā)展的現(xiàn)實(shí)問題����,更是侵權(quán)法必須予以回應(yīng)的重大法律問題。

可喜的是,侵權(quán)法關(guān)于過錯(cuò)的研究頗為豐富�����。通說認(rèn)為��,人類行為過錯(cuò)的判定以“合理的人”為標(biāo)準(zhǔn)��。合理性分析作為基本工具與通道��,已然確立了過錯(cuò)判定的一般框架���,可謂意義重大�����。以“合理的人”這一標(biāo)準(zhǔn)為模板���,已有學(xué)者提出算法的理性標(biāo)準(zhǔn),用以解決算法歸責(zé)難題����;也有學(xué)者提出設(shè)定“理性車”標(biāo)準(zhǔn),用以判斷自動(dòng)駕駛系統(tǒng)的過錯(cuò)�����。只是上述標(biāo)準(zhǔn)聚焦于特殊對(duì)象及特定場(chǎng)景,不具有普適性��。受此啟發(fā)�,本文旨在構(gòu)建人工智能侵權(quán)中的一般過錯(cuò)標(biāo)準(zhǔn)。通過揭示現(xiàn)有人工智能侵權(quán)中過錯(cuò)認(rèn)定的邏輯誤區(qū)��,從機(jī)器行為切入�����,證立機(jī)器行為的可過錯(cuò)性與合理性分析的可拓展性���,提出“合理的人工智能”標(biāo)準(zhǔn)�,嘗試為人工智能侵權(quán)中的過錯(cuò)認(rèn)定提供可行方案����。

為避免混淆,還需就本文所討論的侵權(quán)情形作出如下限定:本文關(guān)于人工智能侵權(quán)中過錯(cuò)的論述�,均以人工智能因自主決策而侵害他人的合法權(quán)益為具體語境。當(dāng)然���,在人類誘導(dǎo)下���,人工智能也會(huì)生成侵權(quán)內(nèi)容。比如����,通過特定技術(shù)手段,用戶可以促使ChatGPT生成暴力����、歧視內(nèi)容。此類情形下���,人工智能具有工具屬性�����,與本文的研究對(duì)象存在明顯差異��,因此不在本文討論范疇���。

二、人工智能侵權(quán)中過錯(cuò)認(rèn)定的邏輯誤區(qū)

長(zhǎng)久以來���,面對(duì)人工智能侵權(quán)����,學(xué)者關(guān)注的是刺破“人工智能面紗”背后的人的行為,包括但不限于生產(chǎn)者�、設(shè)計(jì)者、服務(wù)提供者的行為��,過錯(cuò)標(biāo)準(zhǔn)也緊緊圍繞上述主體展開�����。這實(shí)際上是一種以主體為中心的過錯(cuò)構(gòu)建邏輯(以下簡(jiǎn)稱主體思維)�,即以可能存在的責(zé)任主體為邏輯起點(diǎn),進(jìn)而探究相關(guān)主體的注意義務(wù)范圍�。由此,人工智能侵權(quán)中的過錯(cuò)與相關(guān)主體的過錯(cuò)實(shí)現(xiàn)了同義替換����,相關(guān)主體存在過錯(cuò),那么人工智能就存在過錯(cuò)�,反之亦同。這意味著�����,就人工智能侵權(quán)而言,不存在一個(gè)統(tǒng)一的過錯(cuò)認(rèn)定標(biāo)準(zhǔn)���。與其訴諸于某一特定標(biāo)準(zhǔn),毋寧說是需要設(shè)定關(guān)于相關(guān)主體的龐大的注意義務(wù)體系�,才能夠解決人工智能侵權(quán)中的過錯(cuò)認(rèn)定問題。

基于“人工智能非主體性”的基本共識(shí)�,在現(xiàn)有法律承認(rèn)人工智能的法律主體地位之前,將人工智能侵權(quán)的關(guān)注重心聚焦于人類行為����,是理論與實(shí)踐的默認(rèn)選擇。但是�����,以人類行為作為人工智能過錯(cuò)構(gòu)建的核心�,既是對(duì)“人工智能非主體性”的僵化理解,又顯然缺乏現(xiàn)實(shí)可能性�。

第一,人工智能的主體資格與過錯(cuò)評(píng)判并非事物的一體兩面�,兩者的規(guī)范功能不同。前者關(guān)注某一實(shí)體能否構(gòu)建法律上的權(quán)利義務(wù)關(guān)系��,后者關(guān)注某一行為是否具有合理性�����。鑒于主體通常是行為的發(fā)出者,過錯(cuò)與主體概念相互關(guān)聯(lián)��。在人工智能非主體性的基本預(yù)設(shè)下�,學(xué)者通過否定人工智能的法律地位,進(jìn)而拒絕評(píng)價(jià)機(jī)器行為是否存在過錯(cuò)��。當(dāng)然�,強(qiáng)調(diào)主體概念的差異性無可厚非,本文也無意挑戰(zhàn)現(xiàn)階段“人類作為最終侵權(quán)責(zé)任主體”這一基本共識(shí)��。但是��,將這種差異性繼續(xù)延展至過錯(cuò)要件的討論����,就不再具有正當(dāng)性。原因在于�,就過錯(cuò)判定而言,侵權(quán)行為與責(zé)任主體完全能夠相互分離����。以替代責(zé)任為例,替代責(zé)任要求“行為人之外的人對(duì)行為人的侵權(quán)行為負(fù)責(zé)”��,即實(shí)施侵權(quán)行為的主體無須為侵權(quán)結(jié)果負(fù)責(zé)。例如�����,在用人者責(zé)任中����,勞動(dòng)者因執(zhí)行工作任務(wù)致他人損害的�,用人單位應(yīng)當(dāng)承擔(dān)相應(yīng)的損害賠償責(zé)任?����;蛴匈|(zhì)疑認(rèn)為����,替代責(zé)任中,侵權(quán)行為指向的是人的行為����,在擬人的情境中探討機(jī)器行為,欠缺法律意義���。其實(shí)不然�,正如王利明指出:“侵權(quán)行為是指由于過錯(cuò)侵害他人的人身和財(cái)產(chǎn)而依法應(yīng)承擔(dān)侵權(quán)責(zé)任的行為,以及依法律的特別規(guī)定應(yīng)當(dāng)承擔(dān)侵權(quán)責(zé)任的其他損害行為���。”上述界定為容納多種形態(tài)的侵權(quán)行為提供了空間�,非人類行為亦可被評(píng)價(jià)為侵權(quán)法上的加害行為�。

最典型的情形是,在飼養(yǎng)動(dòng)物損害責(zé)任中��,盡管動(dòng)物飼養(yǎng)人是最終承擔(dān)侵權(quán)責(zé)任的主體�����,但法院分析對(duì)象也同時(shí)指向動(dòng)物的致害行為�,畢竟動(dòng)物致害責(zé)任的構(gòu)成要件之一,就是動(dòng)物危險(xiǎn)的實(shí)現(xiàn)��。故而���,法官必須謹(jǐn)慎地對(duì)動(dòng)物致害行為作出相應(yīng)的法律評(píng)價(jià)���。比如,在“于某某訴何某某侵權(quán)責(zé)任糾紛案”中�,法院在裁判說理時(shí)明確地將動(dòng)物的非接觸行為定性為加害行為。這表明�����,動(dòng)物的非主體資格,并不妨礙動(dòng)物行為作為侵權(quán)過錯(cuò)的判斷對(duì)象����。實(shí)際上,行為作出不僅僅是法律主體才具有的功能�。正如拉圖爾的行動(dòng)者網(wǎng)絡(luò)理論(ActorNetwork Theory)所描述,一切“通過制造差別而改變了事物狀態(tài)的東西”都是行動(dòng)者�����。非人類實(shí)體也能夠以自己的活動(dòng)參與社會(huì)建構(gòu)��。模擬人腦思考的人工智能���,盡管不擁有生物學(xué)意義上的人腦,但是仍會(huì)在與外界環(huán)境的交互中有所反應(yīng)����。因此,以人工智能的非主體性為理據(jù)����,質(zhì)疑機(jī)器行為的可過錯(cuò)性�����,實(shí)則過度夸大了主體的重要性��,而忽視了兩者規(guī)范意義的根本不同�。

第二���,基于實(shí)踐理性����,采用搭建相關(guān)主體注意義務(wù)體系的這一方案�����,顯然欠缺現(xiàn)實(shí)可行性�。一方面,相關(guān)主體的注意義務(wù)內(nèi)容難以確定�。客觀上�����,科技對(duì)注意義務(wù)具有較強(qiáng)的形塑功能��,一項(xiàng)技術(shù)創(chuàng)新會(huì)在無形中增加或強(qiáng)化注意義務(wù)的內(nèi)容,如果技術(shù)更新的速度過快�����,注意義務(wù)的范圍和程度就會(huì)處于不穩(wěn)定狀態(tài)�。加之,人工智能的參與主體非常復(fù)雜����,包括但不限于算法設(shè)計(jì)者、算力開發(fā)商�����、數(shù)據(jù)提供者���、數(shù)據(jù)所有者、平臺(tái)運(yùn)營(yíng)方��、用戶等���。確定由誰承擔(dān)侵權(quán)責(zé)任相當(dāng)復(fù)雜�,學(xué)界對(duì)此問題的討論尚存分歧��。為了實(shí)現(xiàn)負(fù)責(zé)任的人工智能,就需要為“具有系統(tǒng)重要性的相關(guān)主體均設(shè)置相應(yīng)的規(guī)制內(nèi)容與明確的評(píng)價(jià)標(biāo)準(zhǔn)”��。這無疑會(huì)引發(fā)下列難題:構(gòu)建較為穩(wěn)定的注意義務(wù)體系這一目標(biāo)��,與新的義務(wù)內(nèi)容不斷涌入這一趨勢(shì)�����,相互矛盾且不可調(diào)和���。比如�����,有學(xué)者認(rèn)為��,應(yīng)當(dāng)為使用者增設(shè)合理操作義務(wù)����、合理指令義務(wù)甚至過程管理義務(wù)��;也有學(xué)者指出����,生成式人工智能相關(guān)主體應(yīng)當(dāng)履行標(biāo)識(shí)義務(wù)���。實(shí)踐層面,法院在“新華創(chuàng)訴某科技公司案”中�����,明確論述生成式人工智能服務(wù)提供者應(yīng)當(dāng)履行設(shè)立投訴舉報(bào)機(jī)制義務(wù)�����、提示潛在風(fēng)險(xiǎn)義務(wù)及顯著標(biāo)識(shí)義務(wù)�。以上表明,確立完整的相關(guān)主體的注意義務(wù)體系根本不可能實(shí)現(xiàn)�,旨在通過逐一檢驗(yàn)各主體的注意義務(wù)來判斷人工智能的過錯(cuò),反而會(huì)進(jìn)一步導(dǎo)向過錯(cuò)的不可知���。

另一方面��,即使勉力搭建相關(guān)主體的注意義務(wù)體系,也無益于過錯(cuò)的證成���。根據(jù)侵權(quán)行為構(gòu)成的基本理論�,加害行為首先需得滿足要件事實(shí)(行為�、權(quán)利受侵害及因果關(guān)系)��,才可繼續(xù)驗(yàn)證有責(zé)性(過錯(cuò))�。但問題在于�����,先于過錯(cuò)判斷的行為難以被證成��。依據(jù)主體思維��,除非能夠清晰辨識(shí)各主體行為�,否則無法判定主體過錯(cuò)。然而�����,在人機(jī)交互的運(yùn)行機(jī)制下��,損害可能源自多方主體的行為���,這些行為緊密交織�����,幾乎不可能還原為各主體的單一行為�。伴隨人工智能技術(shù)的發(fā)展演進(jìn),機(jī)器行為難以被清晰切割為各個(gè)可識(shí)別的人類行為將成為常態(tài)�。舉例來講,智能機(jī)器人從事家務(wù)活動(dòng)時(shí)�,不慎撞傷家中兒童。由于代碼設(shè)計(jì)�、環(huán)境傳感、軟件運(yùn)營(yíng)與維護(hù)���、使用人指令等行為均會(huì)影響人工智能的行為決策���,試圖厘清機(jī)器行為中的主體原因行為,顯然不具有可行性��。既然難以辨認(rèn)主體行為��,那么探討過錯(cuò)問題實(shí)屬空中樓閣���。由此��,即使能夠從理論上劃定相關(guān)主體的注意義務(wù)群����,也會(huì)因主體的不確定性����,導(dǎo)致過錯(cuò)認(rèn)定喪失前提基礎(chǔ)。

綜上��,以構(gòu)建相關(guān)主體注意義務(wù)體系的方式確定人工智能侵權(quán)中的過錯(cuò)��,不僅是對(duì)主體概念的過度擴(kuò)張運(yùn)用�,完全混淆了相關(guān)主體過錯(cuò)與人工智能過錯(cuò)的關(guān)系。而且此種方案還存在高度不確定性及缺乏現(xiàn)實(shí)價(jià)值的衍生弊病����。因此,在人工智能已經(jīng)全面沖擊現(xiàn)有侵權(quán)責(zé)任體系之時(shí)�,有必要跳出主體思維,為過錯(cuò)要件的認(rèn)定提供更為清晰和更具說服力的標(biāo)準(zhǔn)�����。

三�����、人工智能侵權(quán)中過錯(cuò)的再定位:“合理的人工智能”標(biāo)準(zhǔn)

以“合理的人”概念為參考�,“合理的人工智能”標(biāo)準(zhǔn)的規(guī)范意涵是指:一個(gè)抽象意義上的人工智能應(yīng)當(dāng)如何行為,是一種在特定社會(huì)價(jià)值指引下的擬制的機(jī)器形象。盡管“合理的人工智能”標(biāo)準(zhǔn)的客觀狀態(tài)難以描述����,但正是這種彈性概念才能確保法律與科技的協(xié)同,滿足多維度的規(guī)范需求�����。事實(shí)上����,從解釋論觀察,引入“合理的人工智能”標(biāo)準(zhǔn)���,既是對(duì)客觀過失理論的規(guī)范性理解����,又與侵權(quán)法的過失框架相契合�。從制度功能及法律效果考量,該標(biāo)準(zhǔn)有降低制度成本���、增進(jìn)社會(huì)福利優(yōu)化及促進(jìn)實(shí)質(zhì)正義的諸多社會(huì)價(jià)值�����。

(一)“合理的人工智能”標(biāo)準(zhǔn)的證成

主體思維不足以證明限制機(jī)器行為作為過錯(cuò)評(píng)判對(duì)象的合理性��?��;诜▽W(xué)的類型思維,機(jī)器行為與人類行為享有相同制度評(píng)價(jià)的類型基礎(chǔ)���。機(jī)器行為不僅應(yīng)為人工智能侵權(quán)的過錯(cuò)評(píng)判對(duì)象���,而且與合理性分析具有高度適配性,兩者結(jié)合生成“合理的人工智能”標(biāo)準(zhǔn)���,完全具有理論正當(dāng)性���。

1.機(jī)器行為應(yīng)為過錯(cuò)評(píng)價(jià)對(duì)象

盡管機(jī)器行為源于模型驅(qū)動(dòng)或模型與環(huán)境的交互過程,難以容納情感等倫理要素�����。但隨著過失標(biāo)準(zhǔn)的客觀化�����,倫理要素的影響力已經(jīng)大大降低,考察過失的重心已由分析行為人的主觀狀態(tài)轉(zhuǎn)移至客觀行為本身�。以理性人為例,過失不再以考察行為人的主觀狀態(tài)為核心����,只要個(gè)別行為滿足一般人之注意,就為合理��,反之具有過錯(cuò)����。基于“同等事物相同對(duì)待”的類型思維�����,機(jī)器行為與人類行為不存在本質(zhì)不同����。正如學(xué)者所言:“法學(xué)的類型思維促使人們對(duì)法律事實(shí)的關(guān)注點(diǎn)從事實(shí)認(rèn)定轉(zhuǎn)向?qū)κ聦?shí)的正當(dāng)評(píng)價(jià)。”只要二者在“對(duì)法律評(píng)價(jià)有決定性意義的方面一致”��,就應(yīng)當(dāng)獲得相同的法律評(píng)價(jià)���。雖然機(jī)器行為與人類行為的確在表達(dá)機(jī)制��、生成邏輯等方面存在不同����,但是二者同時(shí)具備行為自主與損害同質(zhì)的類似之處,這是決定兩者均可作為過錯(cuò)評(píng)判對(duì)象的關(guān)鍵依據(jù)�����。

第一�����,侵權(quán)法上的“行為”應(yīng)當(dāng)是自主的行為�,而機(jī)器行為符合這一關(guān)鍵要件�。行為自主性強(qiáng)調(diào),個(gè)體在行動(dòng)時(shí)展現(xiàn)出的獨(dú)立性及自我決定能力���。在此��,重要的不是由主體推定行為自主�,而是要在交互中解讀行為是否符合人類規(guī)范的自主性特征�。由于機(jī)器學(xué)習(xí)算法具備涌現(xiàn)能力及隨機(jī)應(yīng)對(duì)能力,學(xué)者已經(jīng)逐步認(rèn)可機(jī)器行為的自主性���。尤其是�����,支持人工智能生成內(nèi)容可版權(quán)性的學(xué)者����,明確認(rèn)可人工智能的作品創(chuàng)作能力。依據(jù)“舉重以明輕”的法理���,既然人工智能都可以獨(dú)創(chuàng)性地創(chuàng)作作品��,那么機(jī)器行為的自主性不必再證���。從全球人工智能的治理政策考察,承認(rèn)并尊重人工智能的行為自主性已經(jīng)成為主流理念��。其中�,《歐盟機(jī)械條例》特別回應(yīng)了人工智能自主性問題,強(qiáng)調(diào)人工智能在預(yù)設(shè)的任務(wù)和活動(dòng)空間內(nèi)能夠進(jìn)行自主活動(dòng)�����。從技術(shù)維度考察�����,誠(chéng)如學(xué)者指出:“從技術(shù)智能化與其指令執(zhí)行過程的相對(duì)獨(dú)立性上來看,人工智能在社會(huì)生產(chǎn)過程中的自主性是毋庸置疑的���。” 技術(shù)實(shí)踐表明�,人工智能并非工具�����,而更像是嵌入社會(huì)關(guān)系中的“伙伴”�,甚至已經(jīng)演化出類人意志���,具備行為能力與意思表示能力����。例如����,ChatGPT的模型參數(shù)及訓(xùn)練數(shù)據(jù)庫具有同一性,但其就同一問題的回答均不相同���;又如����,盡管程序員以提高人臉識(shí)別準(zhǔn)確率作為算法的功能目標(biāo),但針對(duì)不同人種的人臉識(shí)別偏差率就不取決于設(shè)計(jì)者�����。從司法實(shí)踐觀察�����,北京互聯(lián)網(wǎng)法院還率先作出人工智能生成圖片屬于作品的判決��,足可在一定程度上反映實(shí)務(wù)界對(duì)機(jī)器行為的肯認(rèn)�����。由此可見��,人工智能在與人類交互中生成的機(jī)器行為��,可以根據(jù)環(huán)境的變化采取自主行為���,不再完全處于人類的控制之下��,相反其獲得了對(duì)行為的主導(dǎo)權(quán)����。

第二,行為須得侵害他人民事權(quán)益��,才是侵權(quán)法評(píng)價(jià)的行為���。從機(jī)器行為造成的損害后果來看���,其與人類行為所侵害的權(quán)益種類、程度無根本差異�。就受損權(quán)益范圍而言,所有人類行為可為的損害��,機(jī)器行為也同樣可為����。這是因?yàn)?��,人工智能已?jīng)深度嵌入人類生活實(shí)踐的各個(gè)環(huán)節(jié)�,包括但不限于政務(wù)����、醫(yī)療�����、教育�����、工業(yè)����、生活服務(wù)等領(lǐng)域���。特別是����,隨著人形機(jī)器人產(chǎn)業(yè)的大規(guī)模開發(fā)和應(yīng)用�����,這一領(lǐng)域還在逐步拓展。在可預(yù)期的未來,人工智能對(duì)人類的代替將是全方位的���,幾乎不存在由人類獨(dú)占的行為領(lǐng)域�。就受損結(jié)果而言����,二者均會(huì)造成實(shí)害,而且前者的危害程度遠(yuǎn)超后者�����。一般而言���,侵權(quán)法所救濟(jì)的損害范圍限于個(gè)人損害�����,這是由“加害人—受害人”模型中“一對(duì)一”的特質(zhì)所決定的���。然而,機(jī)器行為致?lián)p對(duì)象指向的并非個(gè)體����,而是某一群體乃至社會(huì)公眾���。一旦人工智能出現(xiàn)故障�����,侵害范圍并不局限于某一個(gè)體����,而是具有持續(xù)性、累積性及擴(kuò)散性�����。比如���,OpenAI公司曾因系統(tǒng)漏洞���,導(dǎo)致大量用戶的姓名、對(duì)話內(nèi)容等個(gè)人信息被泄露�;意大利戶戶送有限公司平臺(tái)因采用歧視算法,侵害了大量外賣騎手的平等就業(yè)權(quán)�����?��?梢?����,機(jī)器行為不僅能夠造成損害����,而且致?lián)p后果的嚴(yán)重程度遠(yuǎn)超人類行為。

以上表明�,盡管目前人工智能尚未獲得法律主體地位,但這并不影響證成機(jī)器行為的可過錯(cuò)性�����。就侵權(quán)行為而言�,依據(jù)同類事物同等處理的法律原則,機(jī)器行為在關(guān)鍵要件上與人類行為彼此相似�,二者在過錯(cuò)評(píng)價(jià)上應(yīng)當(dāng)獲得同等對(duì)待。

2.合理性分析的可拓展性

既然機(jī)器行為能夠作為過錯(cuò)評(píng)判對(duì)象�����,那么尚需討論的是���,應(yīng)當(dāng)依據(jù)何種理論或工具評(píng)判機(jī)器行為的過錯(cuò)����?隨著侵權(quán)法中的過失標(biāo)準(zhǔn)不斷趨向客觀化����,合理性分析已經(jīng)成為判定人類過失必不可少的工具。作為一項(xiàng)成熟的分析工具�,基于以下兩點(diǎn),合理性分析也完全可以應(yīng)用到判定機(jī)器行為的過錯(cuò)之中��。

第一�����,合理性分析與行為的性質(zhì)無關(guān)��。合理性分析旨在將加害行為與其他從事此類活動(dòng)的行為相比較�,檢驗(yàn)其是否符合普遍或一般化的社會(huì)期待。在此���,不論合理性分析指向的對(duì)象是人類行為�,還是機(jī)器行為�����,均不影響其規(guī)范效果��。如果將合理性分析視為計(jì)算機(jī)程序,行為只是運(yùn)行該程序的一個(gè)變量���,只要有可以對(duì)照的一般社會(huì)期待�����,那么就能輸出相應(yīng)的對(duì)比結(jié)果��。申言之�,合理性分析作為一種規(guī)范方法及思維框架����,具有超越行為特性的規(guī)范效力。而且���,恰恰是不同的行為��,才更能凸顯合理性分析作為分析工具的重要功能�����。例如�,已有學(xué)者指出,人形機(jī)器人致害時(shí)�����,應(yīng)當(dāng)比照一般理性人標(biāo)準(zhǔn)設(shè)定算法注意義務(wù)����。這表明����,作為判斷某一行為是否合理的技術(shù)性方法,合理性分析不僅適用于人類行為�,也適用于機(jī)器行為。畢竟合理性分析的核心在于通過法律對(duì)行為的評(píng)價(jià)���,引導(dǎo)和塑造個(gè)體甚至社會(huì)的行為模式����,從而實(shí)現(xiàn)社會(huì)共同認(rèn)可的價(jià)值和原則�。在這個(gè)意義上,正是由于現(xiàn)代社會(huì)的損害已經(jīng)明顯呈現(xiàn)機(jī)器化特征���,損害范圍及結(jié)果的嚴(yán)重程度不容小覷��,所以才更應(yīng)當(dāng)采用合理性分析這一工具�����,合理規(guī)范機(jī)器行為�����,確保技術(shù)進(jìn)步將造福而非損害人類利益�。

第二,合理性分析與機(jī)器行為的技術(shù)特征彼此兼容�����。質(zhì)疑合理性分析適配于機(jī)器行為的一個(gè)重要理由在于��,機(jī)器行為難以解釋不可預(yù)測(cè)���,且處于不斷進(jìn)化之中���。機(jī)器行為的特殊性確實(shí)存在,但能否就此反對(duì)應(yīng)用合理性分析�����,恐怕還有進(jìn)一步思考的余地。一方面�����,就合理性分析而言�,“人工智能為何作出此種行為”并不重要,它需要解決的是“人工智能應(yīng)當(dāng)如何行為”這一問題�����。相較于行為原因���,合理性分析更關(guān)注的是行為結(jié)果,或者說是行為本身�。舉例來講,當(dāng)人們?cè)u(píng)判加害人是否應(yīng)對(duì)其暴力行為負(fù)責(zé)時(shí)�,法律關(guān)注的是行為人的行為方式,是被經(jīng)驗(yàn)感知的事實(shí)層面的行為���,而非行為背后的動(dòng)機(jī)�。同理���,缺乏預(yù)測(cè)性及可解釋性的機(jī)器行為�����,只要仍然是造成實(shí)害的行為����,就能夠適用合理性分析的框架。另一方面��,技術(shù)的更新迭代也不會(huì)對(duì)合理性分析造成實(shí)質(zhì)干擾��,受到影響的只是合理性分析的結(jié)果�����。在此����,應(yīng)當(dāng)嚴(yán)肅區(qū)分分析結(jié)果與分析工具的根本性不同。比如���,隨著技術(shù)改進(jìn)����,自動(dòng)駕駛汽車的一般反應(yīng)速度由10秒降至3秒��。在10秒的標(biāo)準(zhǔn)下,一輛反應(yīng)速度為8秒的自動(dòng)駕駛汽車并不為其事故負(fù)擔(dān)責(zé)任����。但在3秒的標(biāo)準(zhǔn)下,則很可能被認(rèn)定為具有過錯(cuò)�����。以上說明��,技術(shù)更迭在一定程度上會(huì)影響分析結(jié)果���,但并不能影響規(guī)范評(píng)估機(jī)制的貫通性�����。合理性分析作為普適的評(píng)價(jià)工具,能夠在不同的技術(shù)水平下發(fā)揮作用��,與技術(shù)進(jìn)步彼此協(xié)同�。

(二)“合理的人工智能”標(biāo)準(zhǔn)的社會(huì)價(jià)值

相較于為相關(guān)主體設(shè)定龐大的注意義務(wù)體系,確定“合理的人工智能”標(biāo)準(zhǔn)是認(rèn)定人工智能侵權(quán)中過錯(cuò)的更優(yōu)方案�����。該標(biāo)準(zhǔn)既能將法律技術(shù)要素嵌入規(guī)范體系,實(shí)現(xiàn)保障技術(shù)發(fā)展與維護(hù)受保護(hù)權(quán)益的雙重目標(biāo)�;又能彌補(bǔ)現(xiàn)有路徑的不足,彰顯并提升侵權(quán)法的科學(xué)性����,切實(shí)增進(jìn)社會(huì)福祉。

首先����,從社會(huì)成本和資源配置的角度看,“合理的人工智能”標(biāo)準(zhǔn)有利于減少不必要的經(jīng)濟(jì)支出��,避免支付高昂的訴訟成本����,實(shí)現(xiàn)社會(huì)資源的優(yōu)化配置。以人形機(jī)器人致?lián)p案件為例��,采用“合理的人工智能”標(biāo)準(zhǔn)更具優(yōu)勢(shì)�����。依照主體思維�����,法律需要將機(jī)器行為拆解為各主體行為,進(jìn)而分析各主體行為����,比如設(shè)計(jì)行為、運(yùn)營(yíng)行為����、使用行為等是否合理。其中�,受害人需要收集有關(guān)各主體行為的資料,辨識(shí)出某一行為的不合理性����,進(jìn)而才可起訴非理性行為人,要求損害賠償�。但是這一流程存在諸多法律障礙。其一�,機(jī)器行為難以拆解���。隨著人機(jī)交互的復(fù)雜性不斷升級(jí)�����,致?lián)p的機(jī)器行為會(huì)越來越難以被拆解�,并視為各主體行為的總和。其二�����,受害人作為普通的自然人��,根本不可能掌握如此多的材料證據(jù)�,聘請(qǐng)專業(yè)人士取證調(diào)查,無疑會(huì)大幅增加訴訟成本����。加之缺乏相應(yīng)的激勵(lì)機(jī)制,針對(duì)受損輕微案件�����,機(jī)器行為的錯(cuò)誤根本無法得到糾正����。但是,若采用“合理的人工智能”標(biāo)準(zhǔn)��,上述困境便能一掃而空����。因?yàn)榇藭r(shí)法律關(guān)注的不是各主體行為��,而是機(jī)器行為����。造成損害的機(jī)器行為能夠被直接觀察和感知�,無須受害人支付高額調(diào)查費(fèi)以辨識(shí)加害行為。由此�����,受害人收集資料����、固定證據(jù)以及起訴的成本都將大大降低。成本的降低��、簡(jiǎn)便的維權(quán)渠道也會(huì)進(jìn)一步激發(fā)受害人積極維權(quán)的熱情���,既不會(huì)減少人們應(yīng)用人工智能的頻率�,相反還能強(qiáng)化人工智能的功能更新���,實(shí)現(xiàn)可信人工智能的發(fā)展。

其次��,從降低人工智能風(fēng)險(xiǎn)、減少損害發(fā)生的角度看��,“合理的人工智能”標(biāo)準(zhǔn)有利于激勵(lì)相關(guān)主體提升技術(shù)水平�,減少事故發(fā)生。風(fēng)險(xiǎn)社會(huì)��,侵權(quán)法的重要機(jī)理之一就是要預(yù)防損害�。若個(gè)體的注意義務(wù)水平無法維持穩(wěn)定的閾值,那么預(yù)防風(fēng)險(xiǎn)就只是紙上談兵����。不清晰的責(zé)任制度會(huì)增加人工智能的運(yùn)營(yíng)障礙,而“合理的人工智能”標(biāo)準(zhǔn)有助于打破這一隱憂����。盡管目前的技術(shù)水平難以解決算法黑箱的不透明性難題,但是��,誠(chéng)如學(xué)者所言���,為機(jī)器行為設(shè)定一套行為準(zhǔn)則���,并不比為人類行為制定規(guī)則更為虛幻。畢竟機(jī)器行為強(qiáng)調(diào)決策的理性與科學(xué)性,而人類行為模式更易受到情感因素影響��,難以被量化���。通過為機(jī)器行為設(shè)定合理的參考點(diǎn)����,能夠?yàn)橄嚓P(guān)主體提供穩(wěn)定的心理預(yù)期��。與產(chǎn)品領(lǐng)域的ISO標(biāo)準(zhǔn)相類似�,“合理的人工智能”標(biāo)準(zhǔn)在人工智能產(chǎn)業(yè)生命周期的各個(gè)環(huán)節(jié)都發(fā)揮著重要的支撐作用。作為企業(yè)研發(fā)成功與否的核心衡量指標(biāo)��,企業(yè)會(huì)盡最大努力使開發(fā)的人工智能產(chǎn)品或服務(wù)滿足此標(biāo)準(zhǔn)����。在設(shè)計(jì)、研發(fā)�、運(yùn)營(yíng)等環(huán)節(jié)采取合理的注意義務(wù),以最小化現(xiàn)實(shí)可能發(fā)生的事故率����。人工智能產(chǎn)品或服務(wù)的大規(guī)模的商業(yè)化應(yīng)用及用戶反饋,又會(huì)進(jìn)一步推動(dòng)技術(shù)進(jìn)步�����,最終達(dá)到改善技術(shù)缺陷�、降低侵害風(fēng)險(xiǎn)的目標(biāo)。

再次�����,從鼓勵(lì)創(chuàng)新��,支持技術(shù)發(fā)展的角度看���,“合理的人工智能”標(biāo)準(zhǔn)有利于避免寒蟬效應(yīng)�����,為技術(shù)開發(fā)提供良好的商業(yè)環(huán)境和制度環(huán)境�����。其一�����,通過機(jī)器行為設(shè)定合理的閾值�����,能夠使相關(guān)主體理性預(yù)期自己的經(jīng)營(yíng)成本和可能風(fēng)險(xiǎn)����,更加客觀地設(shè)定投資規(guī)劃。如果對(duì)人工智能相關(guān)主體設(shè)定太高的注意義務(wù)�,不僅無法激勵(lì)企業(yè)投入人力資源和技術(shù)資源,反而會(huì)使企業(yè)不敢輕易投入��,產(chǎn)生承擔(dān)過重責(zé)任的擔(dān)憂���,阻礙技術(shù)進(jìn)步�����。其二�,“合理的人工智能”標(biāo)準(zhǔn)能夠與技術(shù)進(jìn)步相互協(xié)同��。在技術(shù)發(fā)展的不成熟期��,“合理的人工智能”標(biāo)準(zhǔn)較低����,與審慎包容�、鼓勵(lì)創(chuàng)新的技術(shù)發(fā)展精神相契合��,有利于促進(jìn)市場(chǎng)自由競(jìng)爭(zhēng)��,提升企業(yè)參與度和創(chuàng)新活力����。在技術(shù)發(fā)展的成熟期��,該標(biāo)準(zhǔn)又能同步提升����,切實(shí)保障用戶權(quán)益,助力人工智能產(chǎn)業(yè)的可持續(xù)高質(zhì)量發(fā)展��。其底層邏輯為:該標(biāo)準(zhǔn)體現(xiàn)了技術(shù)與法律的融合���,而只要設(shè)定一個(gè)合乎技術(shù)發(fā)展水平的標(biāo)準(zhǔn)���,就能鼓勵(lì)企業(yè)以對(duì)人類更有利的方式發(fā)展可信人工智能。概言之���,“合理的人工智能”標(biāo)準(zhǔn)的科學(xué)性既能確保不放任市場(chǎng)失衡����,又能實(shí)現(xiàn)技術(shù)穩(wěn)定發(fā)展的目標(biāo)。

最后�����,從法律概念的開放性角度看��,“合理的人工智能”標(biāo)準(zhǔn)有利于應(yīng)對(duì)風(fēng)險(xiǎn)流變的智能社會(huì)���,構(gòu)建“科技理性和法律理性共同支撐的社會(huì)秩序”�。該標(biāo)準(zhǔn)兼具科技性與規(guī)范性的雙重屬性�。科技性是指���,判定機(jī)器行為是否合理���,必然要以人工智能科技活動(dòng)的一般規(guī)律為基礎(chǔ)。因?yàn)榧夹g(shù)的快速發(fā)展導(dǎo)致機(jī)器行為的合理性判斷結(jié)果時(shí)刻處于變化之中�����。比如���,同一機(jī)器行為在不同的技術(shù)發(fā)展時(shí)期�����,其合理性存在差異���。規(guī)范性是指��,該標(biāo)準(zhǔn)實(shí)為具有法拘束力的價(jià)值判斷����。即使技術(shù)水平相同����,該標(biāo)準(zhǔn)的內(nèi)容也能基于政策考量靈活地決定促進(jìn)或限制某一利益����,選擇考慮的因素及權(quán)重,在無需重塑法律框架的基礎(chǔ)上��,重新設(shè)定其追求的法律價(jià)值���。假使堅(jiān)持主體思維��,那么只能通過事后增加或減少某一個(gè)體注意義務(wù)的方式�,變更過錯(cuò)判定結(jié)果。但是���,“合理的人工智能”標(biāo)準(zhǔn)的復(fù)合屬性卻能微妙地平衡技術(shù)風(fēng)險(xiǎn)及發(fā)展目標(biāo)的沖突�����。這種靈活�����、動(dòng)態(tài)的處理方式將給司法實(shí)踐預(yù)留回旋余地��,避免導(dǎo)向僵化的評(píng)價(jià)體系及結(jié)果��。

四��、“合理的人工智能”標(biāo)準(zhǔn)的建構(gòu)與運(yùn)用

確立“合理的人工智能”標(biāo)準(zhǔn)兼具理論基礎(chǔ)及諸多實(shí)益����。進(jìn)而需要明確的是:“合理的人工智能”標(biāo)準(zhǔn)如何構(gòu)建與運(yùn)用�����?對(duì)此問題的回答,既依賴于靜態(tài)層面解釋什么是“合理的人工智能”標(biāo)準(zhǔn)�����,又需要從動(dòng)態(tài)層面闡述如何判斷機(jī)器行為違反“合理的人工智能”標(biāo)準(zhǔn)���。與此同時(shí)����,“合理的人工智能”標(biāo)準(zhǔn)在典型場(chǎng)景的具體應(yīng)用也有待說明��。

(一)“合理的人工智能”標(biāo)準(zhǔn)的構(gòu)建方法

“合理的人工智能”與“合理的人”作為合理性分析的應(yīng)用成果��,具有相同的理論基礎(chǔ)���,前者借鑒后者的建構(gòu)邏輯是應(yīng)有之義。“合理的人”的建構(gòu)方法���,必須包含價(jià)值判斷�����、合理的人自身狀況和案件環(huán)境三個(gè)部分���。以此類推�,“合理的人工智能”的建構(gòu)方法也應(yīng)當(dāng)圍繞上述三個(gè)要素依次展開��。

第一�����,構(gòu)建“合理的人工智能”標(biāo)準(zhǔn)應(yīng)當(dāng)以整體性價(jià)值為導(dǎo)向�。整體性價(jià)值不以單一價(jià)值為鵠,強(qiáng)調(diào)兼容多元個(gè)體選擇���,整體性地理解各個(gè)價(jià)值沖突����。畢竟��,“合理的人工智能”背后的價(jià)值基礎(chǔ)是多元且動(dòng)態(tài)的�����,既無法統(tǒng)一�,也無法形成唯一的價(jià)值選擇。有鑒于此,為了維持各個(gè)價(jià)值的整體性秩序�,必須要?jiǎng)討B(tài)地認(rèn)定“合理的人工智能”標(biāo)準(zhǔn)所展現(xiàn)的價(jià)值偏好,而無須為各個(gè)價(jià)值賦予固定的價(jià)值位階����。例如,人工智能治理的核心就是要努力維持人工智能發(fā)展與其可能產(chǎn)生風(fēng)險(xiǎn)之間的平衡��。這表明���,發(fā)展自由與安全是“合理的人工智能”標(biāo)準(zhǔn)背后的兩大主要價(jià)值�。那么���,接下來的難題便是��,如何確保發(fā)展自由與安全共存于一個(gè)良性的網(wǎng)絡(luò)中呢�?

當(dāng)前����,面對(duì)人工智能治理難題��,不論是國(guó)內(nèi)法還是國(guó)際法�,各國(guó)立法者達(dá)成的基本共識(shí)為采用風(fēng)險(xiǎn)管理進(jìn)路。歐盟《人工智能法》“序言”第26條明確指出采用“基于風(fēng)險(xiǎn)的路徑”,該法將人工智能風(fēng)險(xiǎn)劃分為不可接受的風(fēng)險(xiǎn)����、高風(fēng)險(xiǎn)、有限風(fēng)險(xiǎn)���、最小風(fēng)險(xiǎn)�����,并針對(duì)不同的風(fēng)險(xiǎn)設(shè)定了不同的義務(wù)�����。我國(guó)簽署的全球第一份人工智能治理的國(guó)際性聲明《布萊切利宣言》�����,同樣以風(fēng)險(xiǎn)管理為基本原則��。國(guó)內(nèi)層面��,《互聯(lián)網(wǎng)信息服務(wù)算法推薦管理規(guī)定》第23條���、《生成式人工智能服務(wù)管理暫行辦法》第3條也明確體現(xiàn)了分級(jí)分類的風(fēng)險(xiǎn)監(jiān)管理念。以風(fēng)險(xiǎn)治理為基本準(zhǔn)則,當(dāng)發(fā)展自由與安全互有沖突時(shí)��,應(yīng)當(dāng)依據(jù)不同的風(fēng)險(xiǎn)等級(jí)動(dòng)態(tài)處理����,促進(jìn)價(jià)值平衡。詳言之�����,當(dāng)風(fēng)險(xiǎn)等級(jí)較低的人工智能致?lián)p時(shí)���,由于其可能產(chǎn)生的財(cái)產(chǎn)及人身損害后果都較為輕微�,“合理的人工智能”標(biāo)準(zhǔn)應(yīng)當(dāng)更偏重于發(fā)展自由�。此時(shí),受害人在享受技術(shù)進(jìn)步的同時(shí)����,對(duì)技術(shù)風(fēng)險(xiǎn)的容忍義務(wù)更高。相反����,當(dāng)風(fēng)險(xiǎn)等級(jí)較高的人工智能致?lián)p時(shí),由于其可能引發(fā)嚴(yán)重的財(cái)產(chǎn)及人身損害��,“合理的人工智能”標(biāo)準(zhǔn)應(yīng)當(dāng)更偏重于安全�����。

第二�����,應(yīng)以技術(shù)指標(biāo)構(gòu)建“合理的人工智能”的自身狀況�����。“合理的人”的自身狀況���,包括能力與知識(shí)兩個(gè)方面�,統(tǒng)稱為認(rèn)知能力�����。與之相似�,“合理的人工智能”標(biāo)準(zhǔn)也需要考慮具體案件環(huán)境下的能力與知識(shí)。有疑問的是���,人的認(rèn)知能力存在差異���,因而法官會(huì)在內(nèi)心區(qū)分各種人物形象��,諸如成人��、兒童����、婦女�、老人等,并依據(jù)價(jià)值衡量形成最終的“合理的人”的擬制形象����。比如,鑒于認(rèn)知能力的差異�,社會(huì)對(duì)于未成年人的行為期待一般低于成年人,對(duì)非專業(yè)人士的行為期許弱于專業(yè)人士�����。但人工智能的認(rèn)知能力又應(yīng)當(dāng)如何判斷呢����?

認(rèn)知科學(xué)理論提醒我們,無論人工智能如何模擬人類智能����,二者仍然存在本質(zhì)不同��。這表明,用以調(diào)整人類認(rèn)知能力的分析框架不可不加變動(dòng)地適用于人工智能�,需得結(jié)合機(jī)器行為的特征適時(shí)調(diào)整。實(shí)際上�����,針對(duì)人工智能����,能力與知識(shí)的區(qū)分并不顯著,而是高度相關(guān)���,這是由人工智能的科技屬性決定的�。作為科學(xué)研究成果�,人工智能的能力與知識(shí)能夠合二為一,集中表現(xiàn)為性能�。因此,在形成擬制的“合理的人工智能”形象時(shí)��,無需區(qū)分對(duì)待上述兩個(gè)要素���。人工智能所接受的訓(xùn)練數(shù)據(jù)越多����,代表其儲(chǔ)備的知識(shí)量越多,能力越高����,性能也就越好。換言之�����,決定人工智能認(rèn)知水平的是基礎(chǔ)模型����、算法性能和訓(xùn)練數(shù)據(jù)集大小等技術(shù)要素。其中��,基礎(chǔ)模型作為“人工智能時(shí)代的新型數(shù)字基礎(chǔ)設(shè)施”���,不僅具有通用性����,而且還具有強(qiáng)大的賦能效果����,是決定人工智能認(rèn)知水平的關(guān)鍵因素����。如果各個(gè)人工智能之間共享一個(gè)大模型����,那么其認(rèn)知能力應(yīng)當(dāng)不相上下�。也就是說,當(dāng)基礎(chǔ)模型一致時(shí)�,除非其他技術(shù)指標(biāo)的對(duì)比結(jié)果存在顯著差異,否則人們無須在認(rèn)知能力上作偏離一般人工智能形象的調(diào)整���。至于其他技術(shù)指標(biāo)�,在何種程度上影響“合理的人工智能”標(biāo)準(zhǔn)����,則需結(jié)合個(gè)案的爭(zhēng)議焦點(diǎn)進(jìn)行判斷。這取決于其他技術(shù)指標(biāo)的差異是否實(shí)質(zhì)影響�、在多大程度上影響了人工智能的選擇和決策。

第三���,“合理的人工智能”標(biāo)準(zhǔn)需要考慮具體的案件環(huán)境����。“合理的人工智能”標(biāo)準(zhǔn)指向具體的時(shí)空和場(chǎng)景,因此��,人工智能所處行業(yè)�、地域、交易環(huán)境變化均會(huì)引起“合理的人工智能”標(biāo)準(zhǔn)的相應(yīng)變動(dòng)�����。例如�,應(yīng)用于交通領(lǐng)域的自動(dòng)駕駛汽車與運(yùn)用于醫(yī)療領(lǐng)域的醫(yī)療機(jī)器人,二者的注意義務(wù)肯定不同���。盡管二者可能采用同一基礎(chǔ)模型進(jìn)行數(shù)據(jù)訓(xùn)練�����,但是不同行業(yè)之間的功能預(yù)設(shè)及任務(wù)差距�,就已經(jīng)決定了注意義務(wù)的差異����。又如,不同國(guó)家在同一時(shí)期的人工智能發(fā)展水平存在高低差異,同一國(guó)家在不同時(shí)期的人工智能發(fā)展水平也存在差異�����,那么其所設(shè)定的“合理的人工智能”標(biāo)準(zhǔn)亦不相同�����。概言之���,“合理的人工智能”標(biāo)準(zhǔn)應(yīng)當(dāng)對(duì)人工智能的環(huán)境變動(dòng)有所反應(yīng)���。由此��,依據(jù)不同場(chǎng)景具體化“合理的人工智能”標(biāo)準(zhǔn)時(shí)���,應(yīng)當(dāng)積極采用類型化思維�。比如����,應(yīng)當(dāng)區(qū)分交易環(huán)境、功能�����、區(qū)域、技術(shù)水平等因素��,分別歸屬至不同類型�����,進(jìn)而設(shè)置不同的注意義務(wù)����。具化應(yīng)用表現(xiàn)為“合理的自動(dòng)駕駛汽車”標(biāo)準(zhǔn)、“合理的人形機(jī)器人”標(biāo)準(zhǔn)或“合理的診療機(jī)器人”標(biāo)準(zhǔn)等�。

此外,鑒于“彈性因素最終要通過法官心理機(jī)制的整合得出確定的結(jié)論”����,完全摒棄法官的自由裁量權(quán),采用客觀唯一的方法塑造“合理的人工智能”標(biāo)準(zhǔn)是不現(xiàn)實(shí)的�����。自由裁量并不意味著法官可以恣意裁判���,相反自由裁量需要依法依證據(jù)作出�����,邏輯推理與經(jīng)驗(yàn)常識(shí)是法官認(rèn)定事實(shí)的重要依托����。其中,法官自我法律意識(shí)及經(jīng)驗(yàn)范圍的提升有利于導(dǎo)向良好的裁判結(jié)果�����。鑒于法官個(gè)人經(jīng)驗(yàn)對(duì)案件事實(shí)的認(rèn)定具有重要作用�,因此在疑難或新型案件中,借鑒他人經(jīng)驗(yàn)用以修正法官的經(jīng)驗(yàn)偏差就顯得尤為必要��。具言之�,由于法官對(duì)于新興科技的掌握能力較弱,為了矯正法官可能存在的認(rèn)知偏差�,提升“合理的人工智能”標(biāo)準(zhǔn)的準(zhǔn)確性���,就有必要引入專家輔助機(jī)制����。專家輔助是指專家僅從技術(shù)角度提供參考信息����,而不作任何規(guī)范判斷����。這有利于補(bǔ)足法官的技術(shù)認(rèn)知短板��,規(guī)范法官行為���,使法官?gòu)囊?guī)范層面作出的具體價(jià)值判斷����,更接近于人工智能應(yīng)有的注意義務(wù)水平���。

(二)違反“合理的人工智能”標(biāo)準(zhǔn)的判斷模型

確定抽象意義上的注意義務(wù)固然重要����,但是義務(wù)違反作為侵權(quán)責(zé)任的發(fā)生基礎(chǔ)����,更需要得到關(guān)注。畢竟僅僅依賴?yán)碚摌?gòu)建尚無法將法律實(shí)踐引向更精細(xì)的方向���。一般而言���,法院在判斷人類過失時(shí)�����,需要以其他人在相同或類似情況下的行為作為參考���。以此類推,法院在判斷機(jī)器行為的過失時(shí)���,也應(yīng)當(dāng)考慮其他人工智能的行為表現(xiàn)�。但也有學(xué)者認(rèn)為��,應(yīng)當(dāng)以人的行為作為判斷機(jī)器行為過錯(cuò)的標(biāo)準(zhǔn)��。實(shí)際上��,無論是以人類行為���,還是以其他機(jī)器行為作為過錯(cuò)參考對(duì)象,都難以得出機(jī)器行為是否合理的判斷��。以下兩種情形能夠說明設(shè)定一元評(píng)估對(duì)象的困難和矛盾�����。

情形1:人工智能的表現(xiàn)優(yōu)于人類行為,卻又差于其他機(jī)器行為��。以自動(dòng)駕駛汽車為例��,假設(shè)人類司機(jī)的剎車反應(yīng)的平均速度為0.7秒�����,某一車企生產(chǎn)的自動(dòng)駕駛汽車A剎車反應(yīng)速度為0.6秒�����,投放市場(chǎng)的自動(dòng)駕駛汽車剎車反應(yīng)的平均速度為0.3秒�����。那么���,在同等駕駛狀態(tài)下��,A因剎車不及時(shí)引發(fā)了交通事故���。那么�,A的剎車行為是否具有過錯(cuò)����?對(duì)此問題的回答,取決于不同行為參照對(duì)象的設(shè)定�����。如果機(jī)器行為與人類行為相比較�,人類剎車反應(yīng)速度通常在0.7秒左右,機(jī)器行為表現(xiàn)更優(yōu)�;如果機(jī)器行為與其他機(jī)器行為作比較,機(jī)器行為則低于其他機(jī)器表現(xiàn)的平均水平��。那么��,優(yōu)于人類行為卻低于其他機(jī)器行為的某一機(jī)器行為���,是否具有過錯(cuò)呢���?當(dāng)然,我們可以為優(yōu)于人類表現(xiàn)的人工智能設(shè)定較高的注意義務(wù)水平��。但是,這將與自動(dòng)駕駛汽車的安全性能整體高于人類的事實(shí)判斷不符���,也會(huì)不可抑制地帶來寒蟬效應(yīng),助推形成一家獨(dú)大的市場(chǎng)格局����,進(jìn)而變相地走向市場(chǎng)壟斷。

情形2:人工智能的表現(xiàn)差于人類行為��,卻又優(yōu)于其他機(jī)器行為���。誠(chéng)然�����,人工智能并非在任何方面都有勝于人類的表現(xiàn)��。從技術(shù)表現(xiàn)看�,雖然人工智能不會(huì)受到疲勞或者壓力等人類弱點(diǎn)的影響���,但其更容易遭受黑客入侵等網(wǎng)絡(luò)攻擊的風(fēng)險(xiǎn)����。又如��,在涉及倫理、道德的選擇上�����,人工智能的表現(xiàn)并不比人類更好�����,也許還會(huì)更差��。如果面對(duì)價(jià)值選擇難題����,人工智能作出的決策不符合一般人類抉擇,卻又優(yōu)于其他機(jī)器行為�����,那么又應(yīng)當(dāng)如何評(píng)價(jià)人工智能的過錯(cuò)呢����?同上一種情形一樣,參照對(duì)象的不同將導(dǎo)向完全相反的過錯(cuò)判定結(jié)果�。

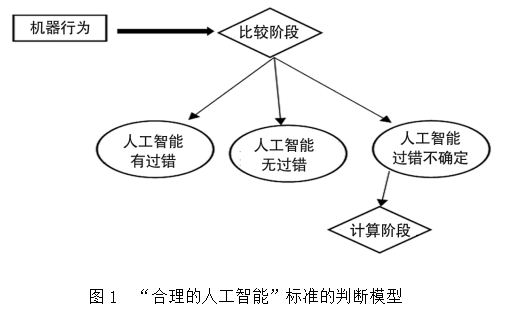

上述兩種情形表明,采用一元評(píng)估對(duì)象的結(jié)論不僅相互矛盾,而且都脫離了一般意義上的法正義觀����。以單一指標(biāo)(人類行為或者機(jī)器行為)作為依據(jù),根本無法得出人工智能是否具有過錯(cuò)的正當(dāng)性結(jié)論��。由此���,不妨設(shè)置一種更為動(dòng)態(tài)、靈活的評(píng)估方法���,同時(shí)將人類行為����、其他機(jī)器行為設(shè)為比照對(duì)象����,嘗試搭建違反“合理的人工智能”標(biāo)準(zhǔn)的判斷模型(見圖1)。此判斷模型區(qū)分為以下兩個(gè)遞進(jìn)階段:一是比較階段����。在比較階段,應(yīng)當(dāng)將機(jī)器行為與人的行為�����、其他機(jī)器行為依次進(jìn)行比較,如果通過比較就能夠確定過錯(cuò)與否���,則不再進(jìn)入下一階段�。二是計(jì)算階段����。只有在上一階段無法判定過錯(cuò)的情形,才需要進(jìn)入計(jì)算階段�。

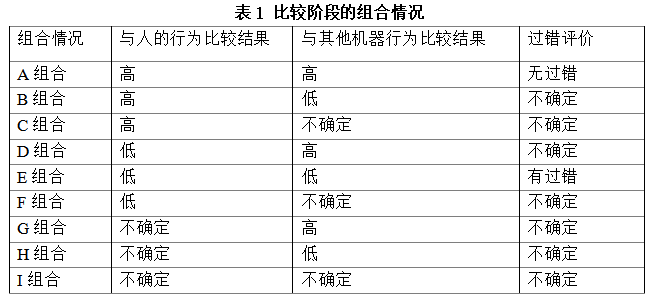

在比較階段,機(jī)器行為與人的行為相比較�����,有可能產(chǎn)生以下三種結(jié)果:高于人類行為(>=)�����、低于人類行為(<)或者不確定���。同樣����,與其他機(jī)器行為相比較,也有可能產(chǎn)生以下三種結(jié)果:高于其他機(jī)器行為(>=)�����、低于其他機(jī)器行為(<)或者不確定��。因此����,混合比較的結(jié)果共有C31×C31=9種組合情況����。其中只有A、E組合能夠得出準(zhǔn)確的過錯(cuò)評(píng)價(jià)結(jié)果�,如表1。

應(yīng)當(dāng)注意的是��,“高”或“低”是一種寬泛而非精確的價(jià)值描述����。從規(guī)范意義上講,行為表現(xiàn)的優(yōu)劣不僅僅是事實(shí)問題���,而是融合了法學(xué)利益衡量的法律問題����。因此,在得出比較結(jié)果的論證過程中�,基于“合理的人工智能”標(biāo)準(zhǔn)的構(gòu)建理念,法官至少應(yīng)當(dāng)考慮以下三個(gè)因素:(1)危險(xiǎn)或侵害的嚴(yán)重性����;(2)行為的效益;(3)防范避免的負(fù)擔(dān)����,即為除去或減少危險(xiǎn)而采預(yù)防措施或者替代行為所需支付的費(fèi)用或不便。此外�,就案件環(huán)境而言,若機(jī)器行為所從事的活動(dòng)沒有特殊性�,那么人類行為標(biāo)準(zhǔn)對(duì)應(yīng)的是一般合理人的注意義務(wù)。若機(jī)器行為從事醫(yī)療��、法律、證券從業(yè)等需要高度技術(shù)能力與專業(yè)能力的行業(yè),與之相對(duì)應(yīng)����,人類行為標(biāo)準(zhǔn)應(yīng)采專家的注意義務(wù)��。例如����,我國(guó)《民法典》第1221條規(guī)定,醫(yī)務(wù)人員在診療活動(dòng)中應(yīng)當(dāng)盡到“與當(dāng)時(shí)的醫(yī)療水平相應(yīng)的診療義務(wù)”�,就是對(duì)醫(yī)務(wù)人員這個(gè)專業(yè)團(tuán)體提出的特殊要求。

至此為止�����,除A����、E之外的剩余7個(gè)組合中,機(jī)器行為的比較表現(xiàn)結(jié)果搖擺于高與低之間���,難以判定機(jī)器行為是否具有合理性。因此��,需要進(jìn)入下一階段——計(jì)算階段�。計(jì)算階段的核心,就是為機(jī)器行為設(shè)置一條比較基準(zhǔn)線��。比較基準(zhǔn)線的設(shè)定原理在于:如果從事某項(xiàng)任務(wù)的人工智能造成的傷害小于所有行為者(包括人類和人工智能)在從事該任務(wù)時(shí)造成傷害的加權(quán)平均值M���,那么機(jī)器行為就無過錯(cuò)�����,反之亦同�。加權(quán)平均值M的計(jì)算應(yīng)嚴(yán)格遵循以下步驟。首先��,計(jì)算人類傷害的平均行為值H����,這需要將人類行為造成的總傷害單元相加,除以人類行為的任務(wù)單元數(shù)�����。其次�,計(jì)算人工智能傷害的平均行為值I,即將人工智能從事某一任務(wù)的總傷害單元相加�,除以人工智能行為的任務(wù)單元數(shù)。再次���,計(jì)算各個(gè)行為的權(quán)重�,WH和WI分別是人類與人工智能所完成某任務(wù)的單元數(shù)的比重��。最后���,計(jì)算加權(quán)平均值M=H×WH+I×WI �。此外,造成事故的機(jī)器行為的傷害率I1����,應(yīng)當(dāng)使用案涉機(jī)器行為造成的傷害單元相加,除以案涉人工智能完成的任務(wù)單元數(shù)�����。

尚需強(qiáng)調(diào)的是��,在判斷過錯(cuò)違反的過程中����,應(yīng)當(dāng)特別限制法官行為,并且關(guān)注機(jī)器行為的異常��。其一����,法官在比較和計(jì)算兩個(gè)階段均享有較大的自由裁量權(quán)���,因此必須從程序上予以限制����。具言之,法官在比較機(jī)器行為與其他機(jī)器行為時(shí)����,要明確其采取的標(biāo)準(zhǔn)。比如��,醫(yī)療機(jī)器人致?lián)p��,法官可以選擇的參考對(duì)象為:某一細(xì)分領(lǐng)域的診療機(jī)器人�、特定領(lǐng)域的診療機(jī)器人或者非特定領(lǐng)域的診療機(jī)器人。不論法官如何選擇����,其均應(yīng)當(dāng)提供詳細(xì)的法律論證,以證明選擇的正當(dāng)性�����。特別是�����,如果無法得出高或低的比較結(jié)論,在計(jì)算加權(quán)平均值M時(shí)��,數(shù)據(jù)的選取要與上述選擇范圍保持一致����。其二,如果機(jī)器行為在某一時(shí)段內(nèi)造成的事故過于頻繁���,那么�����,即使機(jī)器行為的事故率仍保持在合理閾值范圍之內(nèi)�����,也不得再適用“合理的人工智能”標(biāo)準(zhǔn)�����。背后的邏輯為��,當(dāng)機(jī)器行為造成事故后�����,暫且不論人工智能是否具有過錯(cuò)���,企業(yè)也應(yīng)當(dāng)積極調(diào)整技術(shù),修復(fù)或消除漏洞�,防范繼續(xù)出現(xiàn)人工智能侵權(quán)事件。如果企業(yè)怠于履行這一義務(wù)���,導(dǎo)致機(jī)器侵權(quán)事故頻繁上演��,那么就無需繼續(xù)適用客觀過失標(biāo)準(zhǔn)����,因?yàn)闄C(jī)器行為已經(jīng)趨向于“故意”侵權(quán)��。

(三)“合理的人工智能”標(biāo)準(zhǔn)的場(chǎng)景化運(yùn)用

從技術(shù)應(yīng)用深度及權(quán)益受侵害程度兩方面考量���,人工智能在自動(dòng)駕駛領(lǐng)域及診療領(lǐng)域的應(yīng)用規(guī)模較大且持續(xù)擴(kuò)張���,損害也直接關(guān)乎廣大人民群眾的生命財(cái)產(chǎn)安全。其引發(fā)的侵權(quán)事故值得重視且具有典型性��。因此�����,本文以上述兩個(gè)領(lǐng)域的事例為例,分別闡釋“合理的人工智能”標(biāo)準(zhǔn)的具體運(yùn)用��。

事例1:高速駕駛道路上�����,兩輛自動(dòng)駕駛汽車均以時(shí)速100km/h同方向行駛并保持合理車距����。突然,行駛至最前方的大型貨車突遇故障��,車輛熄火停至高速路的第三車道�����。前方自動(dòng)駕駛汽車A遇此緊急情況�����,及時(shí)剎車并調(diào)整車道至第二車道����,后方自動(dòng)駕駛汽車B也及時(shí)降低速度并選擇最為安全的調(diào)整方案�����。B轉(zhuǎn)移至第二車道過程時(shí)與A車發(fā)生追尾,導(dǎo)致B車內(nèi)副駕駛座位人員受傷���,A車車輛尾部受損���。經(jīng)查,A���、B兩輛汽車性能均達(dá)到國(guó)家標(biāo)準(zhǔn)及行業(yè)標(biāo)準(zhǔn)����,無制造��、警示缺陷�����。其中��,A車的制動(dòng)效能及恒定性優(yōu)于B車�。具體數(shù)據(jù)如下:上一年度自動(dòng)駕駛汽車行駛里程數(shù)為80萬公里��,人類司機(jī)行駛里程數(shù)為240萬公里����;自動(dòng)駕駛汽車因追尾造成駕駛內(nèi)人員身體受損事件為300起���,人類司機(jī)因追尾造成駕駛內(nèi)人員身體受損事件為3000起�;上一年度B型號(hào)自動(dòng)駕駛汽車行駛里程數(shù)為20萬公里�,造成了20起追尾損害事故。

事例2:一位高齡患者到醫(yī)院進(jìn)行常規(guī)檢查��,診療人工智能C在收集患者基本信息之后���,根據(jù)患者年齡�、性別及口述癥狀等多要素����,合理建議患者進(jìn)行多項(xiàng)檢查項(xiàng)目,其中不包括心臟缺血檢測(cè)��?;颊咴谶M(jìn)行上述檢測(cè)后未見明顯異狀,但幾日后卻因心肌梗塞死亡����。經(jīng)查����,診療人工智能C性能符合相關(guān)技術(shù)標(biāo)準(zhǔn)���。診療人工智能C未建議患者進(jìn)行心臟缺血檢查的原因?yàn)椋颊呖谑霭Y狀屬于心肌梗死的非典型癥狀�����,診療人工智能既有的訓(xùn)練數(shù)據(jù)庫及后天習(xí)得的實(shí)踐經(jīng)驗(yàn)并未收錄此種癥狀���。數(shù)據(jù)調(diào)查顯示�����,因診療人工智能的建議失誤引發(fā)患者未能及時(shí)治療導(dǎo)致心肌梗死的事故僅此一例����。

事例1中�,B車在突發(fā)事件中的選擇,符合通常情況下人們對(duì)人類司機(jī)與自動(dòng)駕駛汽車的預(yù)期����。當(dāng)前方車輛發(fā)生緊急事故時(shí)���,B車緊急剎車并轉(zhuǎn)移至最近車道的行為具有合理性。但問題是��,在同等情況下����,人類司機(jī)是否也會(huì)與前方的A車追尾?其他自動(dòng)駕駛汽車在平均制動(dòng)效能下����,是否會(huì)與A車追尾?上述問題的答案模糊不清���,這一點(diǎn)與Justine Hsu v. Tesla inc案不同�����。因此��,需要借由數(shù)據(jù)統(tǒng)計(jì)結(jié)果定量計(jì)算B車造成的損害是否偏離了所有行為者的加權(quán)平均值M��。加權(quán)平均值M的計(jì)算過程如下:H=3000起受損事故/240萬行駛里程=0.00125����;I=300起受損事故/80萬行駛里程=0.000375;WH=240萬公里行駛里程/320萬公里行駛里程=0.75����;WI=80萬行駛里程/320萬行駛里程=0.25;加權(quán)平均值M=H×WH+I×WI=0.00125×0.75+0.000375×0.25=0.00103125�����。B型號(hào)車造成的事故率I1=20起受損事故/20萬行駛里程=0.0001�。最后��,兩個(gè)結(jié)果相比較�����,可知B車優(yōu)于“合理的人工智能”標(biāo)準(zhǔn)��,并不存在過錯(cuò)����。

或有學(xué)者主張,應(yīng)當(dāng)采用產(chǎn)品責(zé)任路徑認(rèn)定自動(dòng)駕駛汽車的侵權(quán)責(zé)任�����。仍以此事例為討論對(duì)象,如果適用產(chǎn)品責(zé)任�,那么設(shè)計(jì)者很可能需要承擔(dān)侵權(quán)責(zé)任。這是因?yàn)椋?/span>A車的制動(dòng)效能及恒定性優(yōu)于B車����。假使受害人能夠提供合理的替代設(shè)計(jì),并經(jīng)由風(fēng)險(xiǎn)—效用標(biāo)準(zhǔn)檢驗(yàn)��,那么B車就會(huì)被認(rèn)定為設(shè)計(jì)缺陷���,設(shè)計(jì)者需得承擔(dān)侵權(quán)責(zé)任�。然而����,這無疑徒增設(shè)計(jì)壓力并助長(zhǎng)市場(chǎng)壟斷。事實(shí)上�����,人工智能侵權(quán)適用產(chǎn)品責(zé)任已受到多方質(zhì)疑���,甚至有學(xué)者建議在產(chǎn)品責(zé)任中引入理性算法作為認(rèn)定設(shè)計(jì)缺陷的標(biāo)準(zhǔn)����。以上觀點(diǎn)其實(shí)已經(jīng)背離了產(chǎn)品責(zé)任,轉(zhuǎn)向了“合理的人工智能”標(biāo)準(zhǔn)�。客觀上����,隨著自動(dòng)駕駛汽車的普及,形成一個(gè)合理的自動(dòng)駕駛汽車水平并不困難����。

事例2中,判斷診療人工智能C是否具有過錯(cuò)����,首先需要比較診療人工智能C與人類醫(yī)生的表現(xiàn)�。當(dāng)診療人工智能可以獨(dú)立對(duì)患者提供醫(yī)學(xué)建議時(shí),我們不應(yīng)當(dāng)認(rèn)可其專業(yè)水平可以低于專業(yè)醫(yī)生��。依據(jù)《最高人民法院關(guān)于審理醫(yī)療損害責(zé)任糾紛案件適用法律若干問題的解釋》第16條的規(guī)定�����,醫(yī)生是否合理診療應(yīng)當(dāng)考慮患者病情的緊急程度、個(gè)體差異���、現(xiàn)實(shí)醫(yī)療水平及醫(yī)務(wù)人員資質(zhì)等因素��。鑒于在準(zhǔn)確采集信息的基礎(chǔ)上��,患者所述癥狀并非典型心肌梗塞癥狀����。即使是專業(yè)醫(yī)生�����,也很可能錯(cuò)誤忽視心臟風(fēng)險(xiǎn)����。因此,相比于人類醫(yī)生�,診療人工智能C的表現(xiàn)并不差。此外�����,經(jīng)由大量數(shù)據(jù)訓(xùn)練的診療人工智能��,只能對(duì)數(shù)據(jù)輸入準(zhǔn)確的患者提供精準(zhǔn)的建議。由于算法模型高度依賴數(shù)據(jù)輸入����,限于歷史診療數(shù)據(jù)的遺漏,其他診療人工智能也無法識(shí)別心臟風(fēng)險(xiǎn)并給出相關(guān)檢查指導(dǎo)��。因此�,與其他診療人工智能相比,診療人工智能C的表現(xiàn)也具有合理性���。綜合以上��,診療人工智能C無過錯(cuò)�。

相比于自動(dòng)駕駛汽車��,判定診療人工智能的過錯(cuò)更依賴于定性分析�,而非定量計(jì)算。經(jīng)由比較階段��,通常就能判斷診療人工智能是否具有過錯(cuò)���。究其原因,診療過程往往涉及復(fù)雜的個(gè)體差異及專業(yè)判斷����,某一診療錯(cuò)誤�、遺漏而致患者受損的事故難以被量化指標(biāo)直接捕捉���。除非診療人工智能違背基本醫(yī)理致人損害�,比如�����,診療人工智能開出的醫(yī)囑或藥方明顯與醫(yī)學(xué)原理或規(guī)范相悖�。可是�,在此類事件中,診療人工智能的過錯(cuò)明顯����,根本無量化的必要性。當(dāng)然���,在定性分析時(shí)����,應(yīng)當(dāng)在市場(chǎng)上尋找同類診療人工智能����,結(jié)合具體場(chǎng)景確定理性算法形象�����。同時(shí)�,也要注重收集信息采集準(zhǔn)確率�����、診斷準(zhǔn)確率等指標(biāo)��,這些客觀標(biāo)準(zhǔn)表征了診療人工智能的系統(tǒng)性能��,為比較階段的定性分析提供了堅(jiān)實(shí)的事實(shí)基礎(chǔ)和數(shù)字支撐��。

總之��,正如學(xué)者所言:“理性人假設(shè)是一種方法論邏輯���,為科學(xué)研究所必須”����。“合理的人工智能”標(biāo)準(zhǔn)作為可供對(duì)照的人工智能應(yīng)有的合理形象�,在不同的應(yīng)用場(chǎng)景中具有不同的內(nèi)涵,應(yīng)當(dāng)結(jié)合具體案件確定假定形象并予以具化���。只是���,現(xiàn)實(shí)事故必然比本文所列舉事例更為復(fù)雜,在判斷人工智能是否合理行為時(shí)�,除了考量技術(shù)指標(biāo),亦要重視價(jià)值評(píng)估的規(guī)范判斷�。究竟什么樣的機(jī)器行為可被評(píng)價(jià)為合理,是技術(shù)與政策的雙重問題�。舉例來講,如果事例1的追尾事故調(diào)整為:追尾導(dǎo)致坐于后排寶寶椅上的兒童受傷��。鑒于社會(huì)對(duì)兒童安全的高度重視和廣泛關(guān)注�����,法官很可能限縮數(shù)據(jù)的選取范圍�,以強(qiáng)化侵權(quán)責(zé)任認(rèn)定。又如���,若著重強(qiáng)調(diào)安全價(jià)值���,賦予診療人工智能優(yōu)于人類專家的社會(huì)期待�,那么事例2中的診療人工智能C因掌握大量電子病歷信息��,卻無法識(shí)別非典型癥狀�����,就很可能被法院判定為具有過錯(cuò)���。

結(jié)語

如何認(rèn)定人工智能侵權(quán)中的過錯(cuò)�����,是當(dāng)前侵權(quán)責(zé)任制度亟待解決的重大問題?,F(xiàn)有研究堅(jiān)持行為與主體的同一��,以人的行為作為過錯(cuò)的評(píng)判對(duì)象����,陷入了構(gòu)建相關(guān)主體注意義務(wù)群的理論誤區(qū),故而有必要重新修正�。機(jī)器行為已然超越傳統(tǒng)工具的束縛,演變?yōu)楠?dú)立的行為�,倒逼侵權(quán)法過失標(biāo)準(zhǔn)的范式變革。從解釋論角度觀察,“合理的人工智能”標(biāo)準(zhǔn)仍舊堅(jiān)守了現(xiàn)有侵權(quán)法的過失框架����,并未偏離客觀過失的理論基礎(chǔ)�。從法學(xué)的類型思維出發(fā),機(jī)器行為與人類行為在對(duì)法律評(píng)價(jià)有決定性意義的方面一致���,應(yīng)為過錯(cuò)評(píng)價(jià)對(duì)象����。因此���,打破傳統(tǒng)的以人為中心的路徑依賴����,確立“合理的人工智能”標(biāo)準(zhǔn)��,為機(jī)器行為提供清晰且充分的行為指引��,具有正當(dāng)性及可行性�����。具體而言����,“合理的人工智能”標(biāo)準(zhǔn)的構(gòu)建方法應(yīng)與“合理的人”的構(gòu)建方法保持一致���,但也需要結(jié)合人工智能的本身特性作細(xì)微調(diào)整。相比于確認(rèn)注意義務(wù)�,判斷注意義務(wù)的違反更為關(guān)鍵。因此�,應(yīng)當(dāng)以人類行為和其他機(jī)器行為作為參照對(duì)象,依次經(jīng)過比較和計(jì)算兩個(gè)階段����,搭建違反“合理的人工智能”的判斷模型。此外����,不同場(chǎng)景及案件中的“合理的人工智能”標(biāo)準(zhǔn)也需要相應(yīng)調(diào)整,不僅需要考慮技術(shù)指標(biāo)����,更應(yīng)當(dāng)重視價(jià)值判斷及政策考量。唯其如此���,才能真正化解人工智能侵權(quán)中過錯(cuò)的認(rèn)定困境���,解決大量無法受現(xiàn)行法保護(hù)的救濟(jì)需求����,真正促進(jìn)人工智能產(chǎn)業(yè)的健康有序發(fā)展���。

因篇幅限制���,已省略注釋及參考文獻(xiàn)��。原文詳見《河北法學(xué)》2025年第5期�。